AMD stabilește o nouă frontieră în AI: drumul spre yottascale

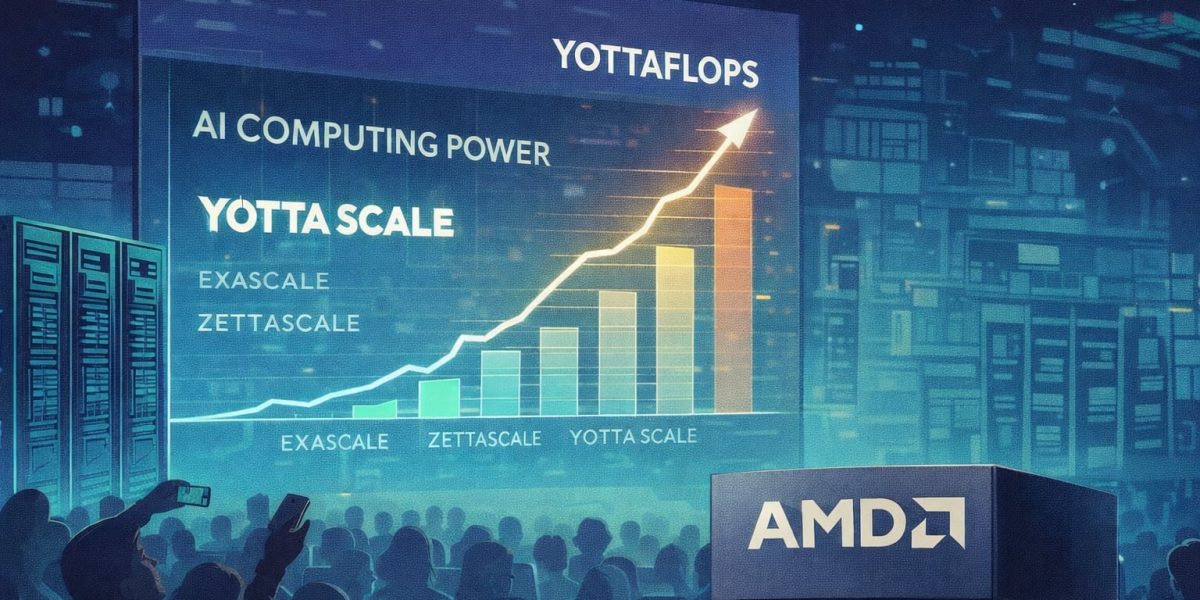

Industria tehnologiei face un salt uriaș în perioada recentă, iar termenul „yottaflops” nu mai e doar un buzzword de marketing, ci devine o realitate tangibilă. În timp ce până acum performanța maximă se măsura în exaflops sau zettaflops, următorul deceniu va aduce computere capabile să efectueze un yottaflop, adică un miliard de ori mai mult. AMD a anunțat oficial că își propune să fie lider în această cursă, navigând spre ceea ce în domeniu se numește „yottascale”, o etapă de dezvoltare a infrastructurii AI considerate a fi o schimbare de paradigmă.

De la performanță la infrastructură: regimul yottascale

Trecerea de la exascale la yottascale nu e o simplă creștere a cifrelor, ci o revoluție în modul în care înțelegem și folosim calculul. Un exascplop reprezintă 10^18 operații pe secundă, un zettaflop ajunge la 10^21, iar un yottaflop sare la 10^24. Diferența nu e incrementală, ci schimbă complet parametrii și limitele tehnologiei. Pentru a ajunge la aceste cifre, nu trebuie să aduni pur și simplu mai multe servere, ci trebuie să concepi o infrastructură distribuită la scară globală, capabilă să funcționeze în mod coordonat, rapid și eficient.

În ultimele ani, evoluția AI a fost marcată de creșteri spectaculoase în capacitatea de procesare a modelelor și seturilor de date. Odată cu lansarea ChatGPT și a supercalculatorului Frontier, primul sistem exascale, benchmark-urile au devenit tot mai ambițioase. Acum, trecerea de la acadea pe termen scurt—antrenarea frecventă a modelelor—la un proces continuu de inferență și raționament, face ca problema scalării să devină critică. Pentru AI modernă, nu mai e vorba doar despre cât de mare e modelul, ci și despre cât de des și cât de complex îl poți mobiliza pentru a răspunde și a învăța în timp real.

Distribuirea și ecosistemul complet, cheia sustenabilității

Ceea ce marchează această etapă de avans e faptul că yottaflopii nu pot fi concentrați în câțiva mari supercomputeri. Mobilitatea și nevoia de reacție rapidă, la scară globală, presupun o rețea distribuită de centre de date, edge-uri și chiar dispozitive locale. În această ecuație, AMD pune accent pe un portofoliu „full stack”, de la hardware la software, argumentând că pentru atingerea yottascale nu este suficient să ai acceleratoare performante, ci trebuie să ai și procesoare care coordonează, rețele eficiente, componente dedicate pentru reducerea overhead-ului infrastructural și un ecosystem robust.

Un proiect strategic în acest sens este „Helios”, o inițiativă care promovează o infrastructură deschisă, optimizată pentru densitatea calculului și eficiența energetică, integrând componente de la CPU-uri și GPU-uri, până la rețelistică și software. Dezvoltarea acestor soluții e menită să facă să devină realitate scalarea la nivel de sistem, nu doar de bucată.

Totodată, ultimele tendințe sugerează că următorul val de tehnologii se va concentra pe reducerea costurilor asociate inferenței, dar și pe capacitatea de distribuție inteligentă între cloud, edge și dispozitive individuale. Cât de bine vor reuși producătorii să controleze aceste aspecte va determina dacă yottaflops va rămâne un target ambițios sau se va materializa în soluții reale pentru industrie și cercetare.

Privirea înainte: o revoluție în infrastructura AI

Pe măsură ce AMD și alte companii mari anunță planuri concrete pentru a atinge aceste niveluri de performanță, devine tot mai clar că transformarea nu se va produce doar prin inovarea chipurilor, ci printr-o rețea complet integrată și adaptată noilor cerințe. Scalarea și sustenabilitatea vor fi cuvintele cheie ale următorului deceniu în AI, iar anunțurile din ultima perioadă indică faptul că suntem abia la începutul unei noi paradigme tehnologice.

În aceste condiții, industria nu se mai poate permite să privească performanța maximă ca pe o simplă țintă de marketing, ci ca pe o componentă a unei infrastructuri globale, eficiente și scalabile, indispensabilă pentru a face față provocărilor viitorului.